Wyszukiwarka Google otrzymuje dziennie miliardy zapytań, z czego 15% to zapytania, które nie pojawiły się nigdy wcześniej. Szukając czegoś, nie zawsze wiemy, jak najlepiej sformułować frazę. Może nam brakować odpowiedniego słowa lub nie znamy jego poprawnej pisowni. I z tym silnik wyszukiwania musi sobie poradzić, bo w końcu skoro go o coś pytamy, to prawdopodobnie dlatego, że czegoś nie wiemy. Wyszukiwarki obecnie dobrze sobie radzą z językiem naturalnym, ale wiadomo, że zawsze może być lepiej. Aby tak było, Google adaptuje nową technikę przetwarzania języka opartą na sieciach neuronowych.

W zeszłym roku Google zaprezentowało otwartoźródłową, opartą na sieciach neuronowych technikę przetwarzania języka naturalnego (NLP) o nazwie Bidirectional Encoder Representations from Transformers — w skrócie BERT. W rzeczywistości pozwala ona każdemu wytrenować swój własny system udzielania odpowiedzi. Model ten przetwarza słowa w relacji do wszystkich pozostałych słów z zdaniu, zamiast przetwarzać je po kolei, słowo po słowie. Dzięki temu BERT rozpoznaje właściwy kontekst słów i próbuje odgadnąć intencje autora zapytania. Niektóre modele zbudowane przy pomocy BERT są tak złożone, że stanowią prawdziwe wyzwanie dla tradycyjnego sprzętu. Z tego też powodu Google po raz pierwszy używa najnowszych TPU (Tensor Processing Unit) w chmurze.

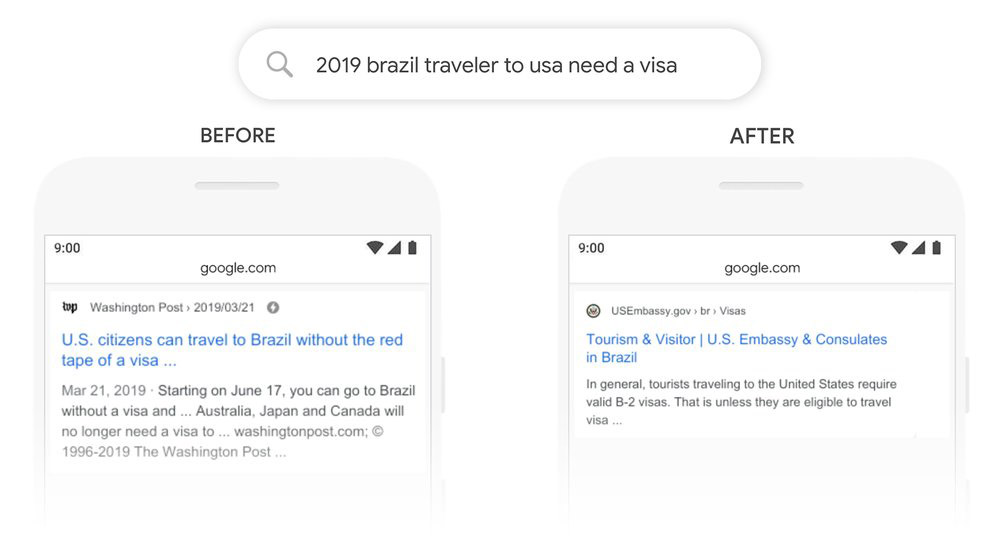

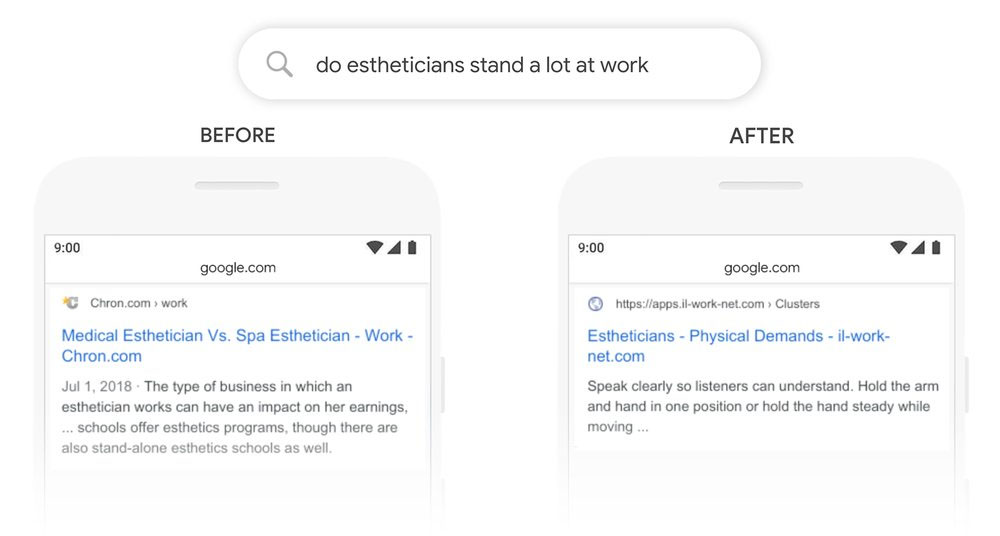

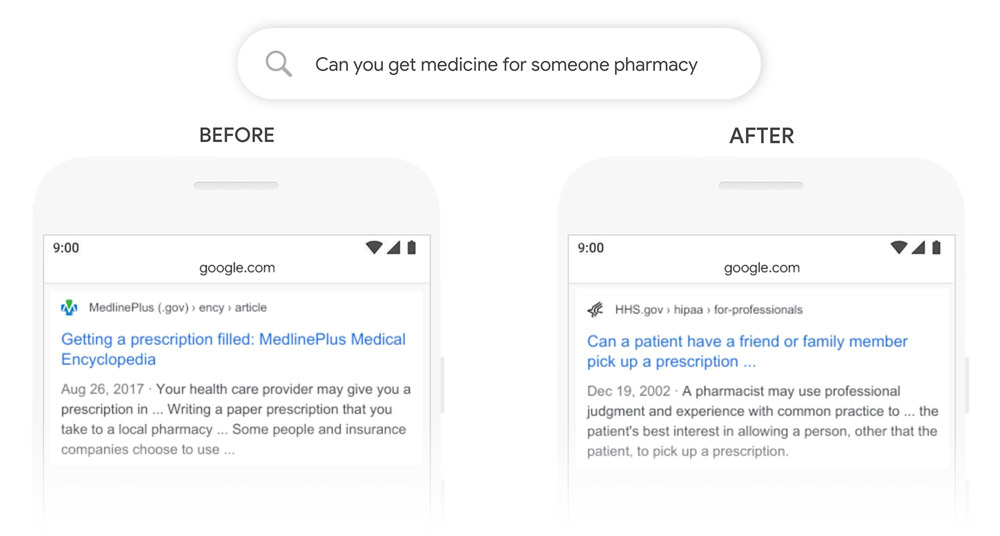

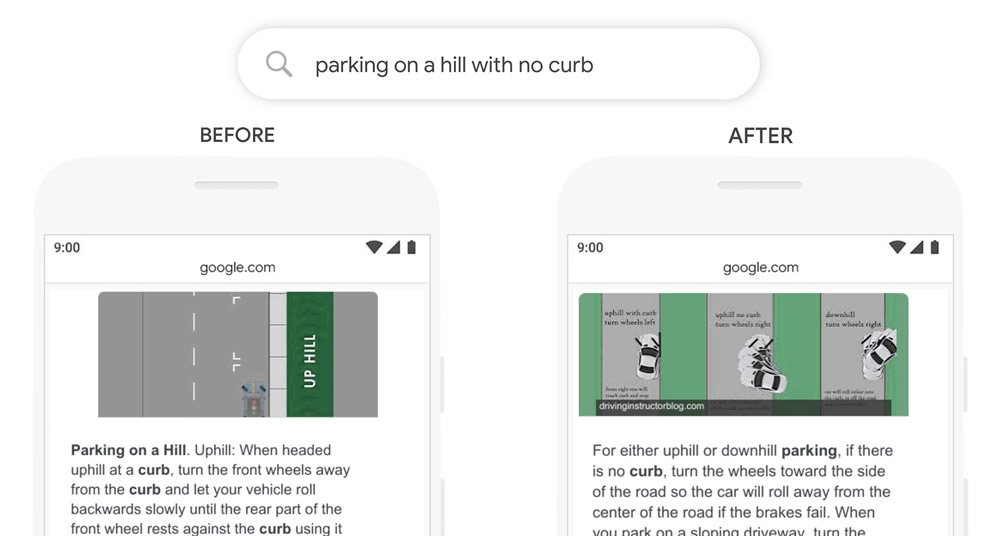

Szczegóły techniczne już znamy, ale co to właściwie oznacza dla użytkownika? Przede wszystkim to, że z większym prawdopodobieństwem Google zwróci mu bardziej przydatne informacje. Już w tym momencie BERT poprawia jakość jednego na dziesięć wyszukań w USA, a z czasem będzie ogarniał więcej języków.

Warto wspomnieć, że również Microsoft wykorzystuje sztuczną inteligencję i głębokie sieci neuronowe, by poprawiać jakość wyników w Bing. Dzięki niej użytkownicy mogą wyszukiwać, posługując się swobodnym językiem czy obrazami, a już niekoniecznie sztywnymi słowami-kluczami, do jakich byliśmy przyzwyczajeni. Więcej na ten temat przeczytacie w naszym wcześniejszym artykule:

a8fe91a.jpg)