Niewątpliwą zaletą chmury jest możliwość zaprzągnięcia dowolnej liczby jednostek obliczeniowych w dowolnym czasie bez konieczności ich fizycznego posiadania. Nazywamy to skalowalnością lub - w przypadku ogromnej mocy obliczeniowej - hiperskalowalnością. Pokaz możliwości Azure widzieliśmy choćby na konferencji Microsoft Ignite 2016, na którym demonstrowano działanie chmury w obliczu takich zadań jak choćby tłumaczenie obszernej powieści w ciągu ułamków sekundy. Microsoft swoją chmurę nazywa "Superkomputerem AI". Połączona moc wielu centrów danych na świecie jest także wykorzystywana przez badaczy, na przykład inżynierów genetyki.

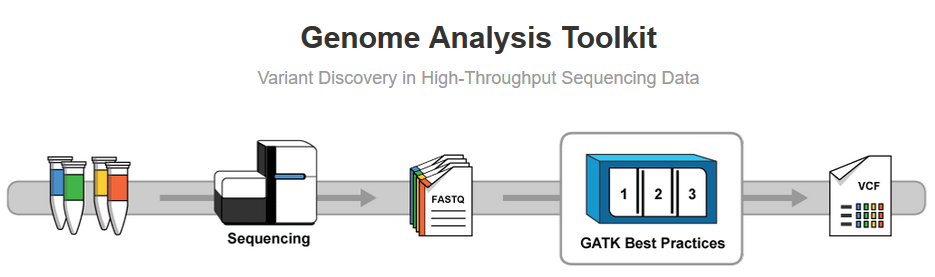

Microsoft Research już od ponad dekady zajmuje się genetyką. Na tym polu dokonano już paru innowacji, by wymienić choćby projekty FaST-LMM dla GWAS, szyfrowanie homomorficzne (pozwalające na operowanie na zaszyfrowanym dokumencie bez jego deszyfrowania, a więc bez znajomości klucza) i projekt Literome. Kolejnym osiągnięciem, którego udało się dokonać dzięki wykorzystaniu chmury, jest znacznie przyspieszony czas obliczeń w sekwencjonowaniu DNA. Metoda z wykorzystaniem Burrows-Wheeler Aligner (BWA) i Genome Analysis Toolkit (GATK) w Azure jest siedem razy szybsza od wcześniej stosowanej wersji, co pozwala naukowcom i badaczom na uzyskanie rezultatów w 4, a nie - jak dawniej - w 28 godzin.

BWA i GATK to dwa najczęściej stosowane narzędzia do sekwencjonowania genomu. Jest to o tyle istotne, że pozwala lekarzom na zdiagnozowanie rzadkich i niebezpiecznych chorób genetycznych szybciej o całą dobę, dzięki czemu leczenie pacjenta można rozpocząć dużo wcześniej. "Istnieje wiele informacji, w odniesieniu do których szybkość jest naprawdę ważna" - mówi Ravi Pandya, główny architekt oprogramowania z grupy Microsoft Genomics. David Heckerman, który jest liderem tej grupy, tłumaczy, że liczba zamówień przetwarzania danych genetycznych ze szpitali, klinik i placówek badawczych rośnie w ekstremalnym tempie: "Zmierza to do punktu, w którym dziesiątki tysięcy genomów są poddawane sekwencjonowaniu, więc wydajność ma tu duże znaczenie".

Przejście na chmurę jest dla wielu instytucji pracujących z big data dobrym rozwiązaniem, bowiem ściąga to z nich ciężar zapewnienia i utrzymania sprzętu do obliczeń (CPU, GPU, FPGA) i przechowywania danych (HDD, SSD). Wiele analiz dowodzi, że jest to wydajniejsze także z ekonomicznego punktu widzenia.