W grudniu zeszłego roku Microsoft wypuścił Phi-4, mały model językowy (SLM) o najwyższej wydajności w swojej klasie. Teraz gigant rozszerza rodzinę tego modelu sztucznej inteligencji o 2 nowe warianty: Phi-4-multimodal oraz Phi-4-mini. Są one nakierowane odpowiednio na pracę z wieloma typami danych jednocześnie oraz osiąganie rezultatów dorównujących dużym modelom przy mniejszym zapotrzebowaniu obliczeniowym.

Phi-4-multimodal - nowy model multimodalny od Microsoft

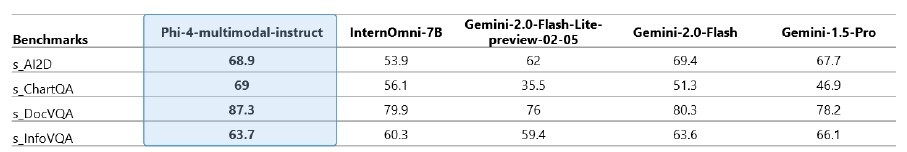

Phi-4-multimodal to model multimodalny, który obsługuje mowę, obraz i tekst jednocześnie. Jest to model AI o 5,6 mld parametrów, a także pierwszy mutlimodalny model językowy Microsoftu, który integruje 3 wspomniane typy zawartości i przetwarza je w pojedynczej, zunifikowanej architekturze. W porównaniu do innych wysokiej klasy modeli omni, takich jak Google Gemini 2.0 Flash czy Gemini 2.0 Flash Lite, Phi-4-multimodal osiąga wyższą wydajność w wielu benchmarkach, co możecie prześledzić w tabeli poniżej.

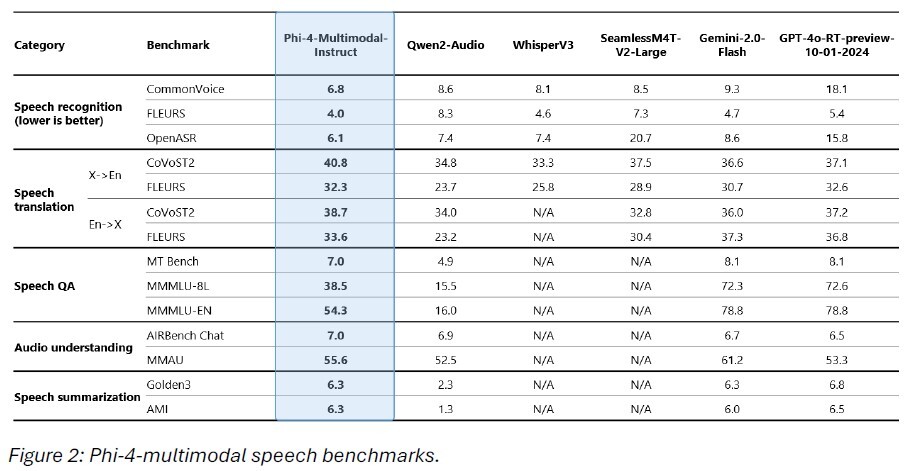

W zadaniach opartych na mowie Phi-4-multimodal prześciga wyspecjalizowane modele mowy, takie jak WhisperV3 oraz SeamlessM4T-v2-Large, zarówno w automatycznym rozpoznawaniu mowy (ASR), jak i tłumaczeniu mowy (ST). Microsoft podaje, że model ten osiągnął najwyższą pozycję na tablicy liderów Hugging Face OpenASR z imponująco niskim współczynnikiem błędów słów (6,14%).

W zadaniach powiązanych z rozpoznawaniem obrazów (computer vision), w tym w zadaniach wymagających wnioskowania w obszarach matematyki i nauk ścisłych, multimodalny wariant Phi-4 również osiąga mocne rezultaty. W przypadku typowych umiejętności multimodalnych, takich jak rozumienie dokumentów i wykresów, OCR i wizualne rozumowanie naukowe, nowy model wyprzedza popularnych rywali, takich jak Gemini-2-Flash-lite-preview i Claude-3.5-Sonnet.

Phi-4-mini - nowy model tekstowy SLM

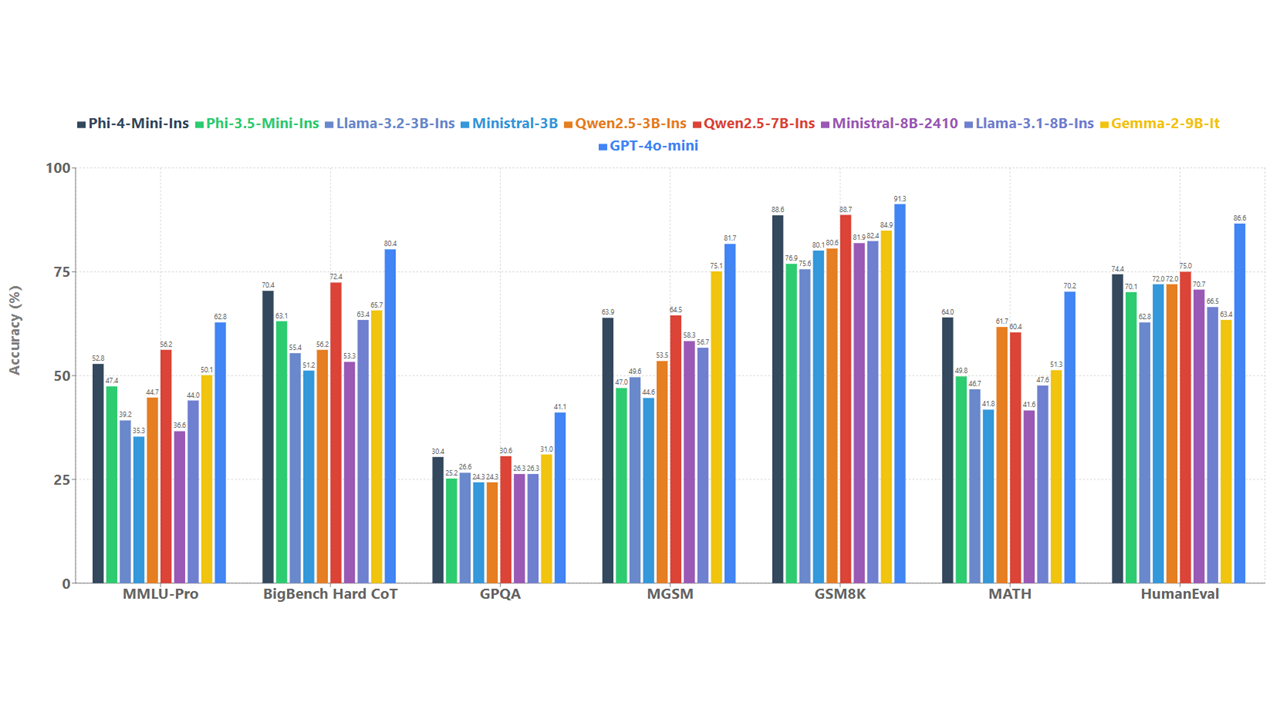

Phi-4-mini to z kolei mały model językowy (SLM) o 3,8 mld parametrów, który wyprzedza parę znanych dużych modeli językowych (LLMs) w zadaniach opartych na tekście. Obejmuje to wnioskowanie, zadania matematyczne, kodowanie, podążanie za instrukcjami i wywoływanie funkcji.

Aby zapewnić bezpieczeństwo tych nowych modeli AI, Microsoft poprowadził testy wspólnie z wewnętrznymi i zewnętrznymi specjalistami z dziedziny security, a także zaimplementował strategie opracowane przez zespół Microsoft AI Red Team (AIRT). Oba modele mogą być wdrażane bezpośrednio na urządzeniu i dalej optymalizowane przy pomocy środowiska ONNX Runtime. Daje im to zgodność międzyplatformową i czyni je to odpowiednimi w scenariuszach zarówno niskobudżetowych, jak i wymagających niskiej latencji.

Phi-4-multimodal i Phi-4-mini są już dostępne dla deweloperów w Azure AI Foundry, Hugging Face oraz NVIDIA API Catalog. Deweloperzy mogą przejrzeć dokumentację techniczną, aby poznać zarys rekomendowanych sposobów użycia modeli oraz ich ograniczeń.

Nowe modele sztucznej inteligencji Microsoftu dowodzą znaczących osiągnięć na polu mniejszej i tańszej AI, która potrafi być równie wydajna, co duże, kosztowne modele działające tylko w centrach danych. Takie niewielkie modele uruchamiające się lokalnie na urządzeniu można z powodzeniem zastosować w aplikacjach AI.