Teksty generowane przez sztuczną inteligencję, taką jak ChatGPT, wzbudzają różne obawy. Technologia została zakazana m.in. w szkołach w Nowym Jorku. Człowiek nie zawsze może wykryć, czy tekst został napisany przez AI, za to sama AI może sobie z tym lepiej poradzić. OpenAI wypuściło właśnie narzędzie, którego celem jest wykrywanie, czy autorem tekstu jest maszyna.

Firma udostępniła narzędzie (klasyfikator) po tym, jak liczne instytucje edukacyjne i okręgi szkolne zbanowały ChatGPT, ponieważ wielu uczniów w całości polegało na nim przy tworzeniu wypracowań. Oprócz Nowego Jorku technologia została zakazana w okręgach szkolnych Seattle, Los Angeles i Baltimore, a także na niektórych uniwersytetach we Francji czy Indiach. Niektóre stany Australii zablokowały również dostęp do ChatGPT w szkolnych sieciach internetowych.

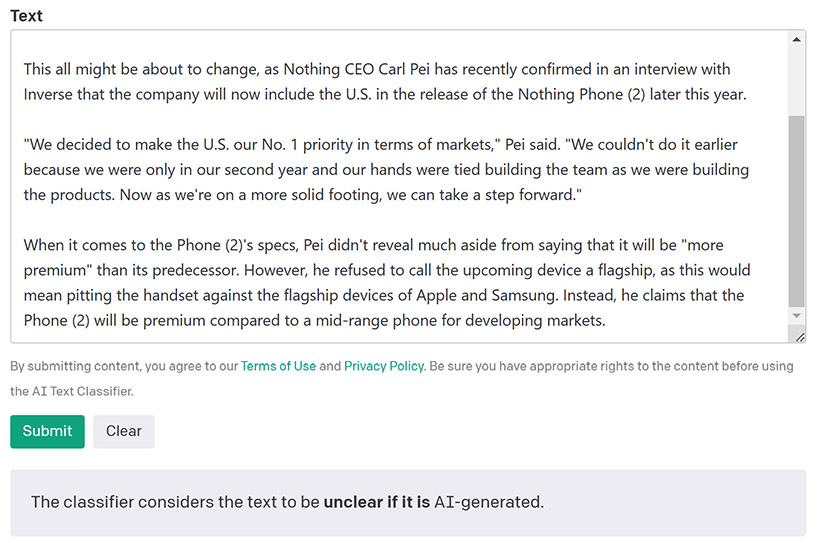

OpenAI określa swój klasyfikator tekstu jako "szczegółowo dostrojony model GPT, który przewiduje, z jakim prawdopodobieństwem tekst został wygenerowany przez AI z różnych źródeł, takich jak ChatGPT". Firma zastrzega jednak, że narzędzie nie jest doskonałe. W jej własnych testach klasyfikator zidentyfikował poprawnie tylko 26% tekstów napisanych przez AI i za takie uznał 9% tekstów napisanych przez człowieka. Co więcej, nie jest on wiarygodny w przypadku tekstów poniżej 1000 znaków oraz tych napisanych w językach innych niż angielski. Klasyfikator nie zawsze jednoznacznie ocenia prawdopodobieństwo. Czasem po prostu podaje, że nie jest w stanie tego określić.

Klasyfikator od OpenAI nie powinien być zatem traktowany jako wyrocznia, a jego ocena nie może być dowodem w sprawie. Włąściwie nie wiadomo jeszcze, jak postępować z takimi przypadkami. Zapewne prowadzony będzie wyścig zbrojeń między AI generującymi teksty i AI wykrywającymi teksty tworzone przez AI. Jak pokazuje to przykład OpenAI, obie technologie mogą być rozwijane przez te same firmy.