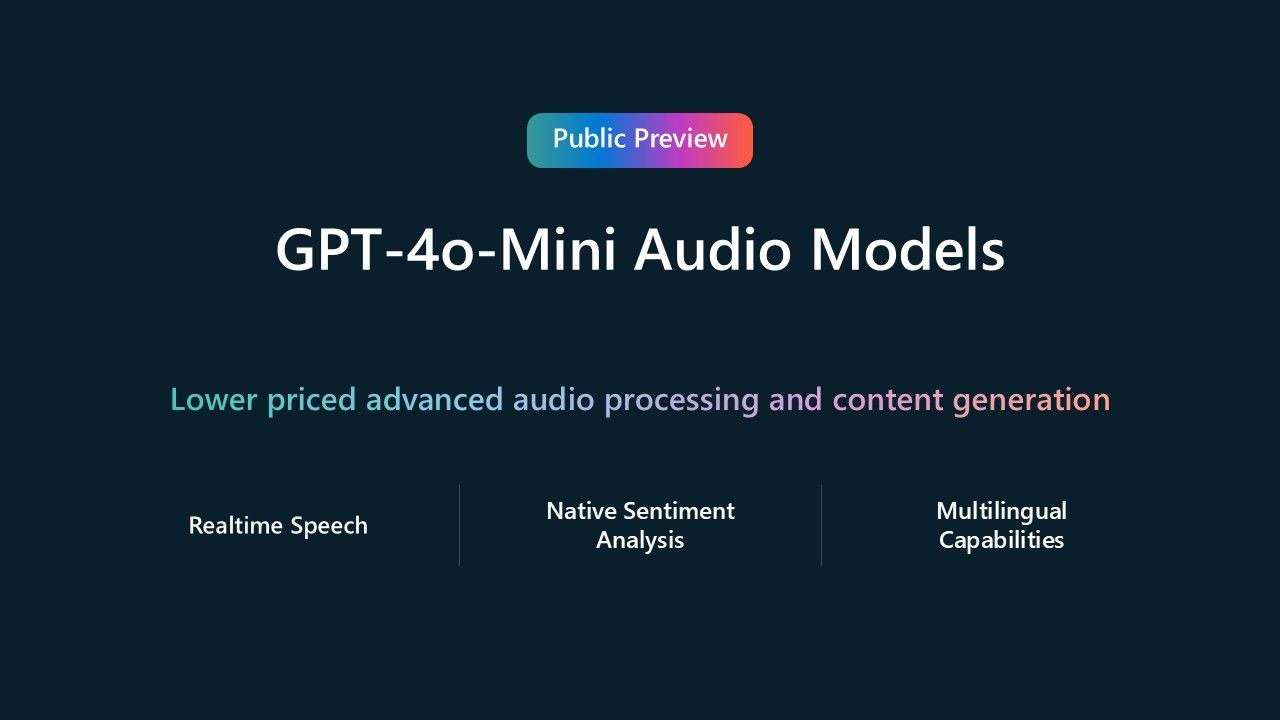

Microsoft wypuścił nowe modele sztucznej inteligencji GPT-4o-Mini-Realtime-Preview oraz GPT-4o-Mini-Audio-Preview, oba w wersji zapoznawczej. Wprowadzają one zaawansowane możliwości przetwarzania dźwięku przy zaledwie 25% kosztu modeli audio GPT-4o. Dzięki temu wzrasta potencjał aplikacji AI w zakresie interakcji opartych na tekście i głosie.

Deweloperzy mogą teraz odblokować immersyjne, kierowane głosem doświadczenia, wykorzystując zaawansowane możliwości wszystkich modeli dźwiękowych Azure OpenAI Service, dostępnych w publicznej wersji zapoznawczej. Przykładowe zastosowania to:

- Obsługa klienta: wirtualni asystenci i czatboty głosowe mogą obsługiwać zapytania klientów bardziej naturalnie i efektywnie, skracając czas oczekiwania i podnosząc ogólną satysfakcję.

- Tworzenie treści: twórcy contentu mogą zrewolucjonizować swoją pracę, wykorzystując generowanie mowy w grach wideo, podcastach czy studiach filmowych.

- Tłumaczenie w czasie rzeczywistym: branże takie jak opieka zdrowotna czy usługi prawnicze mogą czerpać korzyści z tłumaczenia na żywo, które pozwala przełamać bariery językowe i zapewnić lepszą komunikację.

Oba nowe modele zapewniają wysokiej jakości interakcje audio za ułamek ceny modeli dźwiękowych GPT-4o. Są one także kompatybilne z istniejącymi Realtime API oraz Chat Completion API. Czym one się natomiast różnią?

- GPT-4o-Mini-Realtime-Preview: zapewnia naturalne interakcje głosowe w czasie rzeczywistym dla bardziej angażującego doświadczenia użytkownika. Model ten będzie idealny dla aplikacji wymagających natychmiastowych odpowiedzi, takich jak czatboty obsługi klienta i wirtualni asystenci.

- GPT-4o-Mini-Audio Preview: zapewnia wysokiej jakości interakcje audio przy niższych kosztach. To idealny model dla aplikacji wymagających asynchronicznego przetwarzania dźwięku, np. do analizy nastrojów na nagraniu czy tworzenia treści z wykorzystaniem zamiany tekstu na dźwięk (text-to-audio).

Jak widać, modele dostępne w Azure OpenAI Service pozwalają zarówno przetwarzać mowę praktycznie w czasie rzeczywistym, jak też pracować z mową i dźwiękiem w scenariuszach, w których błyskawiczne działanie nie jest aż tak istotne. Co natomiast wydaje się ważne, to możliwość zaprzęgnięcia tych modeli do własnych aplikacji poprzez API, tak aby zamienić je w tzw. AI Driven Apps.