Już kilka lat temu zwracano uwagę na zagrożenia, jakie płyną z deep fake'ów. Teraz, wraz z upowszechnianiem sztucznej inteligencji zdolnej generować całkiem przekonujące obrazy, problem staje się coraz poważniejszy. Microsoft przyjmuje proaktywną postawę, aby temu zapobiec.

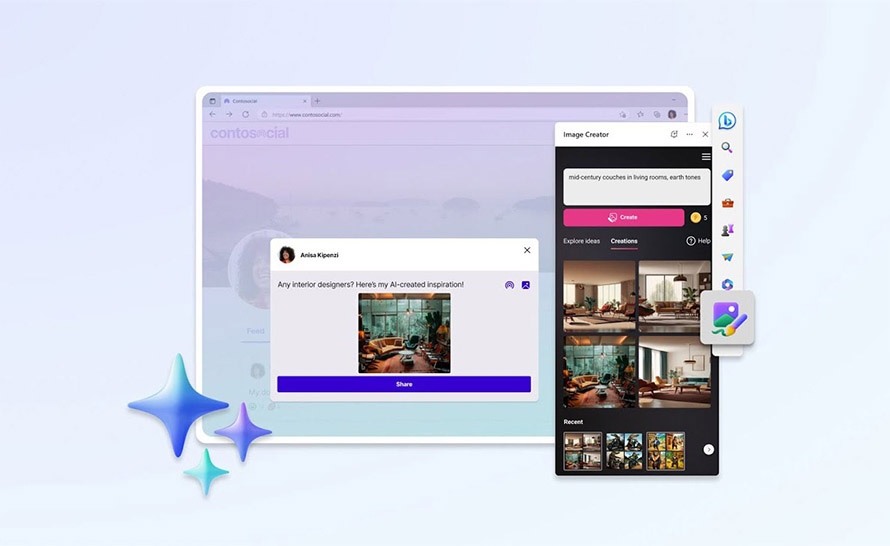

Na konferencji Build 2023 firma ogłosiła, że wkrótce doda funkcję, która pozwoli każdemu sprawdzić, czy obraz lub wideo zostały wygenerowane przez jej narzędzia AI: Bing Image Creator i Microsoft Designer.

Technolgia ta używa metod kryptograficznych, aby oznaczać i podpisywać treści generowane przez AI za pomocą metadanych odnośnie do ich pochodzenia. Microsoft jest liderem w zakresie R&D [ang. research and development] metod uwierzytelniania pochodzenia oraz współzałożycielem organizacji odpowiedzialnej za standardy Project Origin i Coalition for Content Provenance and Authenticity (C2PA). Źródła mediów w Microsoft będą podpisywać i weryfikować treści generatywne zgodnie ze standardem C2PA.

— Microsoft

Microsoft już w 2019 roku ogłosił walkę z deep fake'ami wspólnie z Facebookiem i naukowcami z kilku uniwersytetów. Tworzone są rozwiązania, które mają wykrywać, czy dany obraz lub film zostały sztucznie wygenerowane. Trzeba jednak pamiętać, że większość generatorów w żaden sposób nie oznacza swoich prac, natomiast klasyczne metadane można łatwo usunąć, choćby robiąc zrzut ekranu lub korzystając ze specjalnego programu do czyszczenia metadanych.

Źródło: Official Microsoft Blog