Na przestrzeni ostatniego roku, podczas licznych konferencji deweloperskich Microsoft nakreślił trzy kluczowe obszary dalszych inwestycji: maszynowe uczenie, sztuczna inteligencja i rozpoznawanie mowy. Wszystkie one są mocno zorientowane na przyszłość, kiedy to sposoby interakcji z użytkownikiem będą dla niego dużo prostsze i bardziej przypominające rozmowę z człowiekiem, niż kontakt z interfejsem maszyny. Przyszłość należy do botów, cyfrowych asystentów i aplikacji, silnie związanych z chmurą.

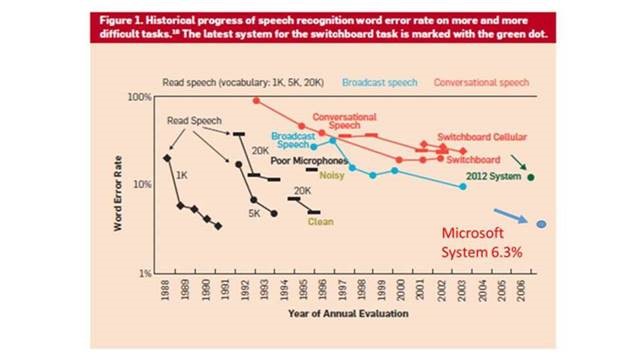

Microsoft już teraz może pochwalić się sporymi osiągnięciami w wymienionych obszarach, czego przykładami są choćby zintegrowane ze Skype boty, API rozpoznające kształty, emocje czy całe scenerie, tłumacz działający w czasie rzeczywistym, a także rozpoznawanie mowy, z którego korzysta m.in. Cortana. Właśnie w tej ostatniej dziedzinie Microsoft odnotował znaczący kamień milowy. Z najnowszego raportu firmy wynika, że jej system rozpoznawania mowy uzyskał najlepszy jak dotąd wynik, co przekłada się na najniższy współczynnik błędu (word error rate). W standardowym dla tego segmentu badaniu Switchboard osiągnięto WER rzędu 6,3% - to najlepszy wynik w całym przemyśle.

Dla porównania: na minionej konferencji Interspeech w San Francisco współczynnikiem 6,6% pochwalił się IBM, a jeszcze wadzieścia lat temu naniższy osiągnięty WER wynosił 43%. "Ten nowy kamień milowy czerpie korzyści z szerokiego asortymentu nowych technologii, rozwijanych przez społeczność AI w wielu organizacjach od ponad 20 lat" - mówi Xuedong Huang, główny specjalista rozpoznawania mowy z Microsoft. Niektórzy naukowcy uważają, że już niebawem technologie rozpoznawania mowy staną się tak dobre, że komputer będzie mógł zrozumieć człowieka na takim samym poziomie, jak inny człowiek. Microsoft owe technologie rozwija pod kątem narzędzi użytkowych - asystentki Cortany, funkcji tłumacza Skype Translator i zorientowanych na język serwisów kognitywnych - a także z myślą o sztucznej inteligencji, która będzie w stanie zrozumieć intencje i potrzeby użytkownika bez zmuszania go do wpisywania poleceń i przedzierania się przez liczne interfejsy.

Inteligentne systemy przyszłości będą widzieć, słyszeć, mówić i rozumieć, przez co korzystać z nich będą mogli nawet ci ludzie, którzy mają problem z obsługą współczesnych systemów i aplikacji (już charakteryzujących się sporą intuicyjnością i prostotą w porównaniu do ich odpowiedników sprzed 20-30 lat). Raport z badań można pobrać ze strony Cornell University Library.